Qu’est-ce que l’extraction de données ?

L’extraction de données est le processus de collecte de données spécifiques à partir de sources d’information pour un affinage et une utilisation ultérieurs dans les processus métier et l’analyse.

L’extraction de données s’applique à tous les types de données provenant à la fois de sources de données structurées et non structurées. Les sources de données structurées, telles que les bases de données et les feuilles de calcul, sont organisées et facilement accessibles, tandis que les sources de données non structurées comme les sites web, les APIs, les fichiers journaux, les images et les fichiers texte nécessitent des méthodes d’extraction plus avancées.

Avantages de l’extraction de données.

Prise de décision améliorée :

L’extraction de données peut fournir des informations à jour pour éclairer les décisions basées sur les données, améliorant ainsi la stratégie commerciale et les résultats.

Meilleure qualité des données :

L’extraction automatisée de données minimise les erreurs dans la migration et le formatage des données, pour des données précises et fiables.

Amélioration de l’efficacité :

L’extraction de données automatisée fonctionne sans arrêt et à grande vitesse, économisant du temps et permettant aux employés de se concentrer sur des activités stratégiques à forte valeur ajoutée.

Création de valeur :

L’extraction de données peut révéler des informations précieuses à partir de fichiers et ensembles de données autrement inutilisables, transformant des données latentes en ressources précieuses telles que des pistes ciblées et des coûts d’exploitation.

Alimentation de l’IA et apprentissage machine :

En distillant tous types de données en dépôts d’informations organisés et centralisés, l’extraction de données peut fournir des nouvelles connaissances de grande valeur pour former des modèles d’IA.

Intelligence économique approfondie :

Elle soutient les initiatives d’intelligence économique, aidant les entreprises à tirer des nouvelles connaissances des données pour alimenter l’innovation et l’avantage concurrentiel.

Économies de coûts :

Elle réduit ou élimine le travail manuel impliqué dans la gestion des données, économisant des ressources et des coûts significatifs.

Gestion des données à grande échelle :

Le logiciel d’extraction de données peut traiter de grands volumes de données provenant de multiples sources ainsi que gérer en douceur des quantités croissantes de données, y compris des changements inattendus de volume.

Extraction des données et ETL.

Le processus d’Extraction, Transformation, Chargement (ETL) est une stratégie en trois phases pour rassembler des informations, améliorer leur utilisabilité et les intégrer dans un écosystème de données.

Commencer par l’extraction de données, cette première phase consiste à puiser dans des sources d’information pour collecter des données essentielles. Semblable à la manière dont la qualité des entrées impacte un produit final, garantir l’extraction de données complètes et fiables prépare le terrain pour le succès de l’ensemble du flux de travail ETL. Dans la phase de transformation, les données brutes extraites sont affinées pour répondre aux objectifs commerciaux. La transformation des données ajoute de la valeur en ajustant les données pour les aligner avec leur utilisation prévue, en supprimant les composantes superflues dans le processus. La phase de chargement représente la livraison des données à leur destination, généralement une base de données, où elles sont prêtes à être utilisées dans les processus métier, la planification et l’analyse.

Chaque partie du processus ETL est indispensable, mais l’extraction des données représente la première étape fondamentale, permettant une transformation et une intégration efficaces des données en aval.

Sources de données :

Avant de commencer un processus d’Extraction, Transformation, Chargement (ETL), les sources de données doivent être identifiées. Les outils ETL peuvent extraire des données brutes de diverses sources, y compris des bases de données structurées et des systèmes CRM, ainsi que des sources non structurées telles que des e-mails et des sites web.

Extraction de données :

Il s’agit de la première étape du processus ETL. Les outils ETL extraient des données brutes des sources identifiées et les stockent temporairement dans une zone de mise en place. En fonction de la source de données et de l’objectif, le processus pourrait utiliser une extraction complète ou une extraction incrémentale. De même, la fréquence d’extraction, qu’elle soit en temps réel ou à des intervalles définis, dépend des besoins spécifiques du processus métier ou de l’objectif.

Transformation des données :

Une fois les données extraites, la phase de transformation commence à nettoyer, organiser et consolider les informations brutes. Les données peuvent subir une variété de transformations, y compris le nettoyage des données, la suppression des données dupliquées et le reformatage.

Chargement des données :

La dernière étape du processus ETL consiste à charger les données transformées. Ces données, désormais raffinées et sans erreur, sont transférées et stockées dans l’entrepôt de données cible. En fonction du volume de données et des exigences commerciales, le chargement peut se faire soit en une seule fois, soit de manière incrémentale. Une fois chargé, les données sont prêtes pour l’extraction et l’analyse.

Méthodes et outils d’extraction de données.

L’automatisation ne peut aller que jusqu’à la disponibilité des données, faisant de l’extraction et de l’organisation efficaces des données le pivot pour automatiser la plupart des processus métier. Différentes méthodes et différents outils d’extraction de données sont utilisés pour rassembler des informations à partir de sources de données dans différents formats. En particulier, les technologies d’automatisation intelligente alimentées par l’IA sont nécessaires pour extraire des données de sources non structurées telles que les e-mails et les documents commerciaux.

Extraction des données structurées

Les données structurées, caractérisées par leur format préorganisé et leur accessibilité facile, résident généralement dans des bases de données, des tableurs et des systèmes de gestion de la relation client (CRM). L’extraction de données structurées a tendance à être simple et utilise une gamme de techniques telles que des requêtes SQL, des appels d’API et des outils de gestion de bases de données spécifiques.

Cependant, les données structurées présentent toujours des défis en matière d’extraction de données. Un volume de données élevé peut ralentir les processus d’extraction, tandis que des données isolées dans des systèmes déconnectés peuvent présenter des complexités d’intégration. Et l’extraction de données sensibles, telles que les informations sur les clients, présente des considérations de confidentialité, de conformité et de sécurité.

Méthodes courantes d’extraction de données structurées :

- Le langage de requête structuré (SQL) est le langage standard pour interagir avec les bases de données relationnelles. Les requêtes SQL sont des outils puissants pour extraire, manipuler et gérer des données.

- Les interfaces de programmation d’applications (API) permettent aux systèmes de communiquer et d’échanger des données de manière programmatique. Ils sont essentiels pour extraire des données des applications et services basés sur le cloud.

- Les outils de gestion de bases de données sont spécialisés dans la gestion et l’extraction de données à partir de sources structurées, offrant généralement des interfaces conviviales avec des capacités supplémentaires, plus avancées disponibles. Les outils spécialisés d’extraction de données comprennent :

- Les outils ETL pour automatiser le processus d’extraction, de transformation et de chargement dans des entrepôts de données.

- Les plateformes d’intégration de données qui facilitent l’intégration de données provenant de plusieurs sources structurées en un seul système.

- Les extracteurs de données CRM extraient des données des systèmes CRM pour l’analyse et le reporting.

Extraction de données semi-structurées

Contrairement aux données structurées, les données semi-structurées ne respectent pas un schéma fixe, mais contiennent des balises et des marqueurs qui fournissent une hiérarchie organisationnelle. Les sources courantes de données semi-structurées incluent les Fichiers XML, les Fichiers JSON et les données web.

L’extraction de données semi-structurées présente un ensemble unique de défis en raison de la variabilité et de la diversité des données, ce qui rend la standardisation et la normalisation plus complexes à réaliser. Semblable aux données non structurées, le volume et la vitesse à laquelle les données semi-structurées sont générées peuvent rendre l’extraction continue des données plus difficile. De plus, certains formats de données, comme les Fichiers XML et JSON, peuvent avoir des structures imbriquées qui nécessitent l’application de techniques d’analyse spécifiques.

Méthodes courantes d’extraction de données semi-structurées :

- Les fichiers XML (eXtensible Markup Language) sont largement utilisés pour la représentation et l’échange de données. Les analyseurs XML sont essentiels pour lire et extraire des données des documents XML.

- JavaScript Object Notation (JSON) est un format d’échange de données léger, populaire pour sa simplicité et sa lisibilité. Les extracteurs de données JSON analysent et traitent les Fichiers JSON.

- Le web scraping implique l’extraction de données à partir de sites web, qui ont tendance à présenter des informations dans des formats semi-structurés. Les outils de web scraping automatisent le processus de récupération des données web.

Extraction de données non structurées

Les données non structurées sont l’enfant terrible de l’information commerciale : elles sont imprévisibles, mais avec un potentiel immense pour créer de la valeur. Et la réalité est que la majorité des données existent dans un format non structuré, dispersées à travers des e-mails, des documents et des discussions, ainsi que des fichiers audio, vidéo et image. Exploiter des sources de données non structurées pour extraire de nouvelles connaissances nécessite des méthodes et des technologies avancées telles que le TLN, l’OCR et des outils d’analyse de texte alimentés par l’IA pour surmonter les défis inhérents au traitement de données complexes qui n’ont pas de schéma prédéfini.

Les défis particuliers de l’extraction de données non structurées incluent le volume et la diversité des données ainsi que leur contexte (p. ex., le sarcasme dans les conversations de chat ou l’utilisation hors contexte de la terminologie) qui créent une complexité sans précédent. Assurer l’exactitude et l’intégrité des données est également un défi en raison du bruit et de la variation inhérents aux sources de données non structurées.

Méthodes courantes d’extraction de données non structurées :

- La technologie de reconnaissance optique de caractères (OCR) convertit différents types de documents, tels que des documents papier numérisés, des PDF ou des images numériques, en données modifiables et consultables.

- Le traitement du langage naturel (TLN) est une technologie clé pour extraire et comprendre le texte non structuré. Le TLN comprend plusieurs techniques :

- Tokenisation : décomposer le texte en mots ou phrases individuels

- Reconnaissance d’entités nommées (NER) : identification et classification des entités telles que les noms, les dates et les lieux.

- Analyse des avis : analyser le sentiment derrière le texte pour évaluer l’opinion publique ou les retours d’information des clients.

- Synthèse de texte : extraction des points clés des grands documents.

- D’autres outils d’analyse de texte alimentés par l’IA combinent des techniques d’apprentissage machine et d’apprentissage profond pour extraire des informations à partir de données non structurées. Les techniques incluent la modélisation de sujets pour identifier les principaux sujets dans un grand corpus de texte, le regroupement pour rassembler des documents ou des extraits de texte similaires, et l’analyse prédictive pour faire des prévisions de tendances futures en utilisant des données historiques.

Cas d’utilisation pour l’automatisation de l’extraction de données.

Services bancaires et financiers

- Traitement des emprunts : l’application de l’extraction automatisée de données aux demandes de prêt permet d’évaluer la santé financière des emprunteurs et leur capacité de remboursement en temps réel.

- Intégration des clients : l’extraction automatique des données des formulaires d’ouverture de compte accélère la création de compte.

- Rapports financiers : l’automatisation de l’extraction de données permet un suivi des dépenses précis et en temps voulu, ainsi que l’établissement de budgets,

- Connaître son client (KYC) : l’automatisation de l’extraction des informations clients à partir des formulaires d’ouverture de compte aide à accélérer la vérification des identités des clients.

Soins de santé

- Gestion des dossiers médicaux : l’automatisation de l’extraction des données accélère l’organisation et la gestion des dossiers médicaux, soutenant l’exactitude et l’accessibilité des informations sur les patients.

- Efficacité administrative : l’automatisation de l’extraction des données réduit la charge administrative tout en augmentant la précision et la rapidité, libérant ainsi le personnel pour se concentrer sur les soins accordés aux patients.

- Conformité réglementaire : l’extraction de données automatise le processus de collecte des données requises à partir de documents liés à la conformité.

- Dossiers électroniques de patients (DEP) : l’extraction automatisée de données permet l’adoption de dossiers électroniques de patients, facilitant le stockage, l’extraction et le partage efficaces des données des patients.

Assurances

- Gestion des documents de polices : l’automatisation de l’extraction de données à partir de documents de police aide à garantir des termes et conditions de couverture d’assurance précis.

- Traitement des demandes : l’extraction automatique de données à partir des formulaires de réclamation permet de capturer les détails de l’incident aussi rapidement que possible.

- Service client : l’utilisation de l’automatisation de l’extraction de données sur les enregistrements de communication aide à suivre les interactions du service client pour améliorer l’expérience client globale.

- Vérification de l’identité : l’automatisation de l’extraction de données à partir de documents de preuve d’identité aide à prévenir la fraude.

Comptabilité et finance

- Traitement des factures : l’extraction de données joue un rôle clé dans l’automatisation du traitement des factures en extrayant avec précision les détails pertinents des factures.

- Conformité fiscale : l’extraction de données à partir des formulaires fiscaux soutient le calcul correct des obligations fiscales et des informations à fournir.

- Rapports financiers : l’automatisation de l’extraction des données des états financiers aide à établir une image précise de la santé financière d’une organisation, soutenant une meilleure prise de décision et transparence.

- Traitement des bons de commande : l’extraction automatisée de données à partir des commandes d’achat permet la création d’enregistrements fiables d’achats, accélérant le traitement des paiements et soutenant la gestion budgétaire.

Évolution de la technologie d’extraction de données.

Une extraction de données meilleure et plus rapide

La collecte, la saisie et la gestion des données commerciales représentaient un effort manuel considérable pour les organisations. Pensez au travail de saisie de données à lui seul. Il a inspiré les nombreux premiers outils d’automatisation de l’extraction de données, tels que l’OCR, pour rationaliser et accélérer les processus d’extraction de données. L’extraction des bonnes informations et la structuration des données dans un format utilisable ont été améliorées par l’introduction et le perfectionnement d’outils comme SQL et les processus d’Extraction, Transformation, Chargement (ETL) qui ont permis l’automatisation de l’extraction des données. Cependant, l’extraction de données est restée en grande partie basée sur des règles et dépendante de données structurées.

Briser la barrière de la structure avec l’apprentissage machine

Avec l’introduction de l’automatisation des processus par la robotique (RPA), l’intégration de l’IA et de l’apprentissage machine (ML) a représenté une avancée majeure dans la technologie d’extraction de données. L’extraction de données plus précise à partir de sources plus diverses et complexes a été rendue possible par des algorithmes d’apprentissage machine qui apprennent à partir de données historiques pour améliorer la précision et l’efficacité au fil du temps. Les modèles d’apprentissage machine, entraînés pour reconnaître et extraire des points de données spécifiques à partir de sources semi-structurées comme des e-mails ou des factures, ont permis une réduction majeure du besoin d’intervention manuelle dans l’extraction de données. Ils ont également facilité l’exploration de données et considérablement augmenté la vitesse de traitement des données.

Compréhension du langage naturel

L’application de la technologie de traitement du langage naturel (TLN) a encore transformé l’étendue et les capacités des outils d’extraction de données. La capacité d’interpréter le langage humain avec des technologies de traitement du langage naturel signifiait que les processus d’extraction de données pouvaient englober des données textuelles non structurées, y compris les demandes des clients et les documents commerciaux, pour extraire des informations précieuses. Les algorithmes TLN vont encore plus loin, permettant la compréhension du contexte, du sentiment et de l’intention des données textuelles non structurées à grande échelle.

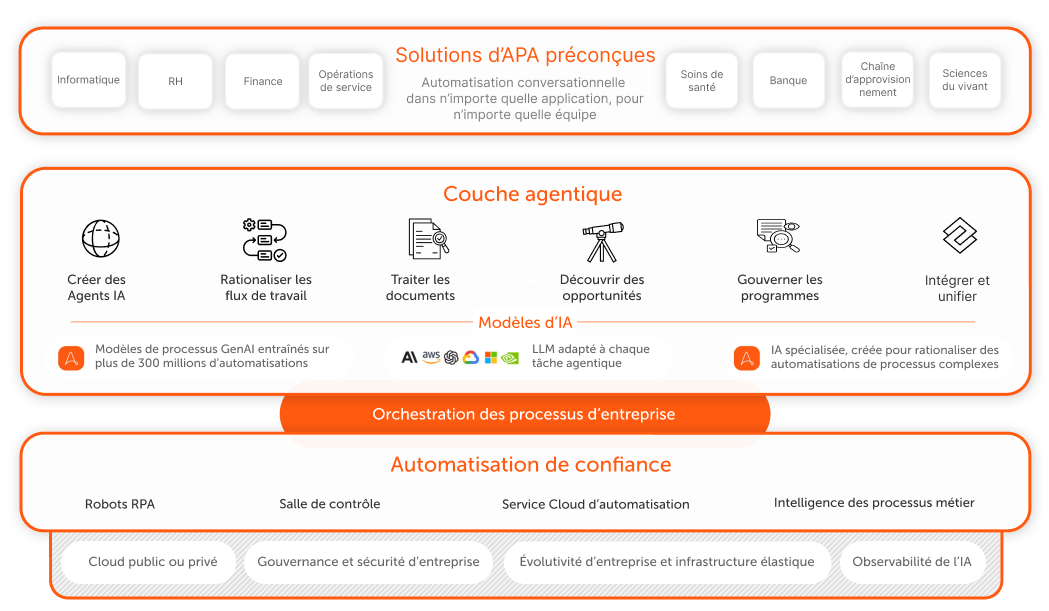

Potentiel infini de l’IA + automatisation

Combiner l’IA, l’apprentissage machine, le TLN et l’IA générative avec des systèmes d’automatisation cognitive ouvre la possibilité d’effectuer des tâches complexes d’extraction de données avec une intervention humaine minimale. Le traitement intelligent des documents (IDP) et les systèmes avancés d’automatisation propulsée par l’IA sont capables de comprendre le contexte, d’apprendre à partir de nouvelles données et de s’adapter au changement. Ils rendent presque toute tâche d’extraction de données ouverte à l’automatisation, y compris les sources de données non structurées telles que l’audio, la vidéo et les images. L’extraction de données alimentée par l’IA permet aux organisations de collecter et de capitaliser sur les nouvelles connaissances et la valeur au sein de répertoires de données en constante expansion pour en tirer des nouvelles connaissances approfondies et alimenter l’innovation dans l’économie axée sur les données.

Premiers pas avec l’automatisation de l’extraction de données.

Identifiez les sources de données

Étant donné que les données extraites dépendent de leur source, identifier votre source de données est un point de départ évident pour mettre en place tout processus d’extraction de données. Les données sources pour l’extraction peuvent inclure des bases de données, des sites web, des journaux ou même des documents physiques.

Concevez le flux de travail d’extraction de données

Examinez chaque étape du processus d’extraction pour cartographier le flux de travail et définir des règles pour la gestion et le traitement des données. Commencez par établir la connexion à vos sources de données, puis extrayez les données, transformez-les, validez-les et enfin chargez les données dans leur destination.

Développez et testez

En fonction de la source de vos données, vous devrez utiliser différents outils d’extraction de données et techniques, tels que le web scraping, les requêtes de base de données, les appels d’API, l’OCR, l’analyse de fichiers et le TLN. Prévoyez des tests complets dans un environnement bac à sable ou autre environnement contrôlé et documentez entièrement le processus d’extraction de bout en bout pour soutenir tout dépannage potentiel.

Déployer et planifier

Planifiez l’extraction pour qu’elle s’exécute à des intervalles spécifiques ou en fonction de certains déclencheurs ou conditions afin d’assurer une productivité maximale et une perturbation minimale.

Surveillez et maintenez

Surveillez le processus d’extraction pour garantir la qualité et l’exactitude continues des données. Un examen et un entretien réguliers peuvent aider à éviter des erreurs inattendues ou des problèmes de performance dus à des fluctuations du volume de données ou à des changements dans le format source. Enfin et surtout, assurez-vous d’établir des protocoles de sécurité des données et des examens de conformité.

Tirez pleinement parti de vos données avec une solution complète d’automatisation intelligente.

Obtenez les capacités d’extraction de données les plus avancées avec Document Automation, intégrées dans le système d’entreprise IA + Automatisation d’Automation Anywhere. Identifiez, collectez et injectez des données de manière transparente dans tout processus ou flux de travail.