データ抽出とは?

データ抽出とは、ビジネス プロセスや分析において精度を向上させて使用するため、情報源から特定のデータを収集するプロセスです。

データ抽出は、データベースの構造化の有無を問わず、あらゆる種類のデータに適用されます。 データベースやスプレッドシートなどの構造化データソースは、整理されているためアクセスが容易ですが、ウェブサイト、API、ログファイル、画像、テキストファイルなどの非構造化データソースは、より高度な抽出方法が必要になります。

データ抽出のメリット

意思決定の強化:

データ抽出は、データ駆動型の意思決定を支える最新の情報を提供し、ビジネス戦略と成果を改善することができます。

データ品質の向上:

自動データ抽出は、データ移行とフォーマットにおけるエラーを最小限に抑え、正確で信頼性のあるデータを提供します。

効率性の向上:

自動データ抽出は、停止することなく高速で実行され、時間が節約されるため、従業員は戦略的で高価値の活動に集中できるようになります。

新たな価値の創造:

データ抽出は、通常は使用できないファイルやデータセットから貴重なインサイトを発見するため、埋もれていたデータを、ターゲットとなるリードや運営コストのような貴重なリソースに変換することができます。

AI と機械学習の活性化:

データ抽出は、あらゆる種類のデータを整理された中央集約型情報リポジトリに抽出することで、AI モデルのトレーニングに価値の高いインサイトを提供できます。

より高度なビジネス インテリジェンス:

ビジネス インテリジェンスの取り組みをサポートし、企業がデータからインサイトを得て、革新と競争優位性を促進できるように支援します。

コストの削減:

データ管理に関わる手作業を削減または排除し、重要なリソースとコストを節約します。

大規模なデータ処理:

データ抽出ソフトウェアは、複数のソース起源のデータを大量に処理できる他、データ量の増大や予想外のデータ量の変動にも対応します。

データ抽出と ETL

ETL(抽出、変換、格納)プロセスは、情報を収集し、使いやすさを向上させ、データ エコシステムに統合する 3 段階の戦略です。

まず最初の段階であるデータ抽出では、情報源にアクセスして重要なデータを収集します。 入力の品質は最終的な製品に影響を与えますが、それと同様に、信頼性の高い包括的なデータを抽出することが ETL ワークフロー全体の成功の基盤となります。 変換の段階では、抽出された生データがビジネス目標に適合するように精選されます。 データ変換は、データを用途に合わせて調整し、処理に不要な要素を取り除くことで価値を追加します。 格納の段階では、データを宛先(通常はデータベース)に配信します。配信されたデータはビジネス プロセス、計画、分析で使用できる状態になります。

ETL プロセスの各段階はいずれも不可欠ですが、データ抽出は最初の基盤となるステップであり、下流のデータ変換と統合を効果的に行うために重要です。

データソース:

ETL(抽出、変換、格納)プロセスを開始する前に、データソースを特定する必要があります。 ETL ツールは、構造化データベースや CRM システムを含む多様なソースの他、メールやウェブサイトなどの非構造化ソースからもデータを抽出できます。

データ抽出:

これは ETL プロセスの最初のステップです。 ETL ツールは、特定されたソースから生データを抽出し、一時的にステージング領域に保存します。 データソースと目的に応じて、プロセスは完全抽出または増分抽出を使用します。 同様に、抽出の頻度は、リアルタイムであるか設定された間隔であるかにかかわらず、ビジネスプロセスや目的の具体的なニーズによって異なります。

データ変換:

データが抽出されると、変換の段階が開始され、生の情報が整理、編成、統合されます。 データは、データ クレンジング、重複データの削除、再フォーマットなど、さまざまな変換を経由します。

データの格納:

ETL プロセスの最後のステップでは、変換されたデータを格納します。 精選してエラーを除去されたデータが、ターゲット データ ウェアハウスに転送され、保存されます。 データ量とビジネス要件に応じて、格納は一度にすべて行うことも、段階的に行うこともできます。 データが格納されると、取得と分析の準備が整います。

データ抽出の方法とツール

自動化は利用可能なデータの範囲でしか実行できないため、効果的なデータ抽出と整理が、ほとんどのビジネス プロセスの自動化にとって重要となります。 さまざまな形式のデータソースから情報を収集するために、多様なデータ抽出方法とツールが使用されます。 特に、AI を活用したインテリジェント オートメーション技術は、メールやビジネス文書などの非構造化ソースからのデータ抽出に必要とされます。

構造化データの抽出

構造化データは、事前に整理された形式と容易なアクセス性が特徴であり、通常はデータベース、スプレッドシート、および顧客関係管理(CRM)システムに保管されています。 構造化データの抽出は比較的簡単で、SQL クエリ、API 呼び出し、特定のデータベース管理ツールなど、さまざまな技術が使用されます。

ただし、構造化データにもデータ抽出の課題があります。 データ量が多いと抽出プロセスの速度が低下し、データが分断されたシステムにサイロ化されている場合は統合が複雑になる可能性があります。 また、顧客情報などの機密データの抽出には、プライバシー、コンプライアンス、セキュリティに関する考慮事項が伴います。

構造化データの一般的な抽出方法には次のようなものがあります。

- 構造化クエリ言語(SQL)は、リレーショナル データベースとやり取りを行う標準言語です。 SQL クエリは、データを抽出、操作、管理するための強力なツールです。

- アプリケーション プログラミング インターフェース(API)を使用すると、システムはプログラムを使って通信し、データを交換できます。 これは、クラウドベースのアプリケーションやサービスからデータを抽出するために不可欠です。

- データベース管理ツールは、構造化されたソースからのデータ抽出に特化されており、通常はユーザーフレンドリーなインターフェースを提供し、より高度な機能も利用可能です。 専門的なデータ抽出ツールには、次のようなものがあります。

- ETL ツールは、データ抽出、変換、データ ウェアハウスへの格納のプロセスを自動化します。

- データ統合プラットフォームは、複数の構造化されたソースから単一のシステムへのデータの統合を容易にします。

- CRM データ抽出ツールは、分析と報告のために CRM システムからデータを抽出します。

半構造化データの抽出

構造化データと異なり、半構造化データは固定されたスキーマに従っていませんが、組織階層を提供するタグやマーカーが含まれています。 半構造化データの一般的なソースには、XML ファイル、JSON ファイル、ウェブデータなどがあります。

半構造化データの抽出は、データの変動性と多様性に伴う独自の課題があり、標準化と正規化の実現がより複雑になります。 非構造データと同様に、半構造データは膨大な量が高速で生成されるため、継続的なデータ抽出がより困難になる可能性があります。 さらに、XML ファイルや JSON ファイルのような一部のデータ形式は、ネストされた構造を持つことがあり、その場合、特定の解析技術の適用が必要になります。

半構造化データの一般的な抽出方法は、次のとおりです。

- 拡張マークアップ言語(XML)ファイルは、データの表現と交換に広く使用されています。 XML パーサーは、XML ドキュメントからデータを読み取り、抽出するために不可欠です。

- JavaScript Object Notation(JSON)は、そのシンプルさと可読性で人気のある軽量データ交換フォーマットです。 JSON データ抽出ツールは、JSON ファイルを解析して処理します、

- ウェブスクレイピングは、情報を半構造化形式で提示する傾向があるウェブサイトからデータを抽出します。 ウェブスクレイピングツールは、ウェブデータを取得するプロセスを自動化します。

非構造化データの抽出

非構造化データは、ビジネス情報における野生児のようなものです。 予測することは困難ですが、価値を生み出す非常に大きな可能性を秘めています。 現実には、データの大部分はメール、ドキュメント、チャット、音声、ビデオ、画像ファイルなど、非構造化された形式で散在しています。 構造化されていないデータソースを活用してインサイトを引き出すには、NLP、OCR、AI 搭載テキスト分析ツールなどの高度な手法と技術が必要です。これらは、定義済みのスキーマがない複雑なデータを処理する際の固有の課題を克服するために使用されます。

非構造化データ抽出の特有の課題には、データの量と多様性、チャットの会話における皮肉的な表現や文脈から切り離された語句の使用など、前例のない複雑さを生み出すコンテキストが含まれます。 非構造化データソースに固有のノイズや変動により、正確性とデータの整合性を確保することも課題となっています。

非構造化データの一般的な抽出方法は、次のとおりです。

- 光学文字認識(OCR)技術は、スキャンした紙の文書、PDF、デジタル画像など、さまざまな種類のドキュメントを、編集と検索が可能なデータに変換します。

- 自然言語処理(NLP)は、非構造化テキストの抽出と理解の中核になる技術です。 NLP にはいくつかの技術が含まれます。

- トークン化: テキストを個々の単語やフレーズに分解します。

- 固有表現抽出(NER): 名前、日付、場所などのエンティティを特定し、分類します。

- 感情分析: テキストの背後にある感情を分析して、世論や顧客のフィードバックを判断します。

- テキストの要約: 大量の文書から重要なポイントを抽出します。

- その他の AI 搭載テキスト分析ツールは、機械学習と深層学習技術を組み合わせて、非構造化データからインサイトを引き出します。 技術には、大量のテキストの主要なトピックを特定するためのトピック モデリング、類似する文書やテキスト スニペットをグループ化するためのクラスタリング、過去のデータを使用して将来のトレンド予測を行うための予測分析などがあります。

データ抽出オートメーションの事例

銀行・金融サービス

- 融資処理: 融資申請に自動データ抽出を適用することで、借り手の財務状況と返済能力をリアルタイムで評価できます。

- 顧客オンボーディング: 口座開設フォームからデータを自動的に抽出することで、口座設定を高速化します。

- 財務報告: データ抽出の自動化により、正確でタイムリーな経費追跡および予算編成を支援します。

- 本人確認(KYC): 口座開設フォームから顧客情報を自動抽出することで、顧客の身元を迅速に確認できます。

医療

- 医療記録管理: データ抽出の自動化を使用すると、医療記録の整理と管理が高速化し、患者情報の正確性とアクセス性が向上します。

- 管理効率: データ抽出の自動化は、管理業務の負担を軽減し、精度と速度を向上させ、スタッフが患者ケアに集中できるようにします。

- 法令遵守: データ抽出は、コンプライアンス関連の文書から必要なデータを収集するプロセスを自動化します。

- 電子カルテ(EHR): 自動化されたデータ抽出により、電子カルテの導入が可能になり、患者データの効率的な保存、取得、および共有が容易になります。

保険

- 保険証券管理: 保険証券からデータを自動抽出することで、保険の適用条件を正確に把握できます。

- 請求処理: 請求フォームからデータを自動抽出することで、インシデントの詳細を可能な限り迅速に把握できます。

- カスタマー サービス: 通信記録にデータ抽出の自動化を使用することで、カスタマー サービスのやり取りを追跡し、全体的な顧客体験を向上させることができます。

- 本人確認: 身分証明書からのデータ抽出を自動化することで、不正使用に役立てることができます。

会計・財務

- 請求書処理: データ抽出は、請求書から関連する詳細情報を正確に引き出すことによって、請求書処理の自動化において重要な役割を果たします。

- 税務コンプライアンス: 税務書類からのデータ抽出は、税務義務と開示の正確な計算をサポートします。

- 財務報告: 財務諸表からのデータ抽出を自動化することで、組織の財務状況を正確に把握し、意思決定と透明性を向上させることができます。

- 発注書処理: 発注書からの自動データ抽出により、信頼性の高い購入記録の作成が可能になり、支払い処理が高速化され、予算管理が改善されます。

データ抽出技術の進化

より適切で迅速なデータ抽出

ビジネスデータの収集、入力、管理は、組織にとって多いな手作業の負担が発生することを意味していました。データ入力だけを考えてみても、その労力は明らかです。このような背景から、OCR などの最初のデータ抽出オートメーション ツールが生まれ、データ抽出プロセスの効率化と高速化が図られるようになりました。 適切な情報を抽出し、データを使用可能な形式に構造化する機能は、SQL や ETL(抽出、変換、格納)プロセスなどのツールの導入と改良によって改善され、データ抽出の自動化が実現しました。 しかし、データ抽出は主にルール ベースであり、構造化データに依存していました。

ML により構造の壁を打破

ロボティック・プロセス・オートメーション(RPA)の導入とともに、AI と機械学習(ML) の統合はデータ抽出技術における大きな進歩を実現しました。 より多様で複雑なソースからのより正確なデータ抽出は、歴史的データから学習して時間とともに精度と効率を向上させる ML アルゴリズムによって可能になりました。 ML モデルは、メールや請求書などの半構造化ソースから特定のデータポイントを認識し抽出するようにトレーニングされており、データ抽出における手動介入の必要性を大幅に削減し、データマイニングを可能にし、データ処理の速度を劇的に向上させました。

自然言語の理解

自然言語処理(NLP)技術を適用することで、データ抽出ツールの範囲と性能はさらに進化しました。 NLP 技術を用いて人間の言語を解釈できるということは、データ抽出プロセスが顧客の問い合わせやビジネス文書を含む非構造化テキストデータを対象として、価値のある情報を収集できることを意味します。 NLP アルゴリズムはさらに進化し、非構造化テキストデータのコンテキスト、感情、意図を大規模に理解できるようになるでしょう。

AI とオートメーションによる無限の可能性

AI、機械学習、NLP、生成 AI を認知型オートメーション システムと組み合わせることで、最小限の人間の介入で複雑なデータ抽出タスクを実行する可能性が開かれます。 インテリジェントドキュメント処理(IDP) および高度な AI 駆動型オートメーション システムは、コンテキストを理解し、新しいデータから学び、変化に適応する能力を持っており、音声、ビデオ、画像などの非構造化データソースを含むほぼすべてのデータ抽出タスクを自動化の対象とすることができます。 AI を活用したデータ抽出により、組織は増大するデータ リポジトリでインサイトと価値を収集して活用し、より深いインサイトを得て、データ駆動型経済においてイノベーションを促進できます。

データ抽出オートメーションの始め方

データソースを特定する

抽出するデータはそのソースに依存します。したがって、データ抽出プロセスを設定するにはまずデータ ソースを特定することから始めます。 抽出のためのソースデータには、データベース、ウェブサイト、ログの他、物理的な文書も含まれる場合があります。

データ抽出ワークフローを設計する

抽出プロセスの各段階を調査して、ワークフローを計画し、データの取り扱いと処理のルールを定義します。 データソースへの接続を設定することから始め、次にデータを抽出し、変換、検証を経て、最後にデータをその宛先に格納します。

開発とテスト

データのソースに応じて、ウェブスクレイピング、データベース クエリ、API 呼び出し、OCR、ファイル解析、NLP など、異なるデータ抽出ツールと技術を使用する必要があります。 サンドボックスまたはその他の制御された環境での包括的なテストの計画を立て、トラブルシューティングの発生に備え、エンドツーエンドの抽出プロセスを完全に文書化します。

デプロイとスケジュール

生産性を最大限に高め、中断を最小限に抑えられるように、抽出を特定の間隔で、または特定のトリガーや条件に基づいて実行するようにスケジュールします。

監視と保守

継続的なデータの品質と正確性を維持するために、抽出プロセスを監視します。 定期的なレビューとメンテナンスは、データ量の変動やソース形式の変更による予期しない障害やパフォーマンスの問題を回避するのに役立ちます。 最後に、データセキュリティ プロトコルとコンプライアンス レビューを確立します。

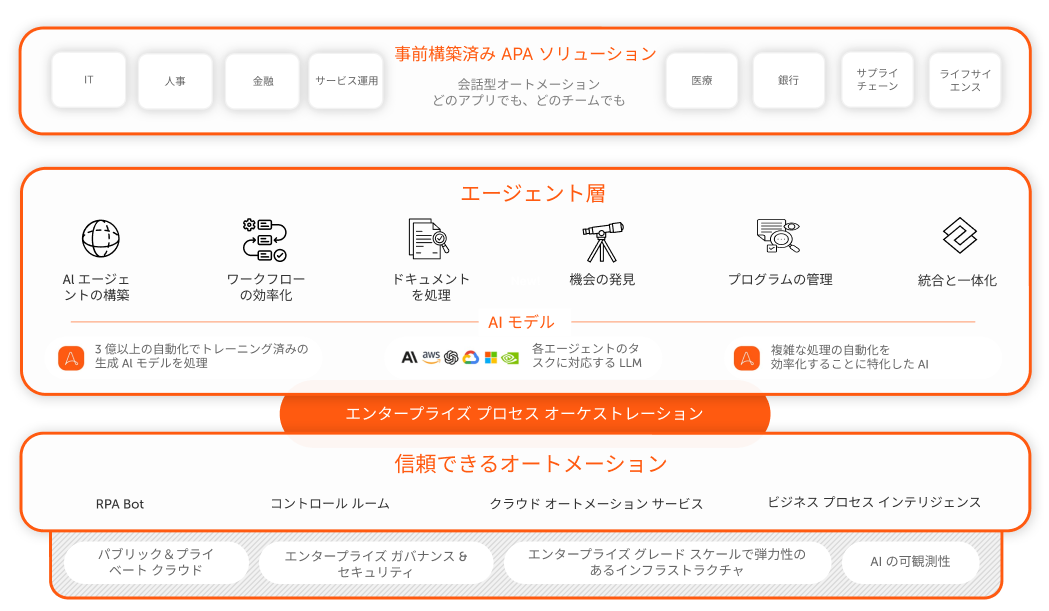

完全なインテリジェント オートメーション ソリューションにより、データから最大限の価値を引き出す

Automation Anywhere の AI + Automation Enterprise System に組み込まれた Document Automation を利用して、最先端のデータ抽出機能を手に入れましょう。 シームレスにデータを特定、収集し、任意のプロセスまたはワークフローに投入できます。